De scope van dit artikel betreft AI-software: ofwel Machine Learning-enabled Medical Devices (MLMD) genoemd of Artificial Intelligence/Machine Learning (AI/ML)-Based Software as a Medical Device (SaMD) [1,2]. Software als medisch hulpmiddel dat gebruik maakt van AI/machine learning. Het gaat hier om een subset van AI waarbij er vooraf geen regels geprogrammeerd door de mens, maar sprake is van een lerend vermogen van de computer door patroonherkenning.

In de basis verschilt AI-software op een aantal punten met andere medische technologieën. Zo heeft het de eigenschap om (1) continu verbeterd te worden, om (2) onderdeel te worden van een groter systeem, om (3) aanbevelingen te doen, en (4) een correlatie aan te duiden en geen causaal verband [3]. Binnen Europa is het aantal gecertificeerde medische hulpmiddelen met een vorm van AI sinds 2015 fors gestegen [4]. Tegelijkertijd zie je dat er van die gecertificeerde AI-toepassingen nog weinig bekend is over de doelmatigheid in de zorg [5]. Meestal zijn de effecten in de klinische praktijk nog onvoldoende onderzocht, mede omdat AI-software nog niet op grote schaal wordt ingezet in de zorg [6]. En juist de prestatie van AI-software hangt samen met de context waarin het toegepast wordt, welke kan verschillen in een andere omgeving of organisatie. Met de dynamiek van de omgeving en van de technologie zelf zal in de regulatie van AI-software steeds meer nadruk gelegd worden. Continue monitoring van AI-software in de eigen organisatie wordt daarom nog belangrijker [7].

Wat is verantwoorde AI?

Het antwoord op deze vraag zal verschillen afhankelijk van wie het vraagt wordt. Zo ook binnen het Maasstad Ziekenhuis (MSZ), een topklinisch ziekenhuis in Rotterdam-Zuid. De meeste zorgprofessionals zijn het erover eens dat het gaat over veilig, ethisch en effectief gebruik van AI in de zorg. Samengevat gaat verantwoorde AI over AI die een positieve impact heeft op de kwaliteit van zorg en tegelijkertijd publieke waarden waarborgt [8]. Uit de literatuur blijkt dat de organisatie en sturing rondom data en AI een belangrijke factor is voor de verantwoorde implementatie van AI in de klinische praktijk [9]. Het gaat over een proces van begin tot eind, met een duidelijk klinisch probleem, ontwikkel- en evaluatieproces, en de betrokkenheid van relevante stakeholders. Tegelijkertijd wordt verantwoorde AI niet alleen maar bepaald door regels en richtlijnen. De manier waarop kennis over verantwoorde AI in de praktijk gevormd wordt is ook een belangrijke factor [10]. Daarom wordt er binnen het MSZ nadruk gelegd op “leren door te doen” bij de implementatie van AI-software. Want juist door de samenwerking van zorgverleners met een multidisciplinair team kunnen de omstandigheden zo worden gecreëerd dat de inbedding van AI-software kan omgaan met de dynamiek van de dagelijkse praktijk [11].

Beter inzicht in de kwaliteit van AI-software

Voor zorgverleners heeft verantwoorde AI vooral te maken met vertrouwen. Zij willen tenslotte een goed product dat “doet wat het moet doen”. Hierbij komt de verantwoordelijkheid van de zorginstelling ook om de hoek kijken. Deze komt uiteindelijk neer op “een veilig medisch hulpmiddel in handen van een getrainde gebruiker in een zorgomgeving die veilig gebruik kan garanderen” [12]. Steeds meer ziekenhuizen hebben beleid voor de inzet AI [6]. Binnen het MSZ zijn hierbij een aantal uitgangspunten belangrijk. Zo wordt er geen apart beleid gevoerd voor AI-software, maar sluit deze volledig aan bij de levensloop van medische informatietechnologie [13]. En omdat het veld zich razendsnel ontwikkelt worden nieuwe richtlijnen als handvaten gebruikt [14]. De vertaling van de huidige best-practices is gedaan binnen het ontwerpproject voor de opleiding tot klinisch informaticus in het Maasstad Ziekenhuis. Het resultaat is het Healthy AI (HAI) stappenplan om beter inzicht te creëren in de kwaliteit van AI-software [15]. Met de eigenschappen van AI-software, lokale validatie, en real-world monitoring als belangrijkste kwaliteitscontroles. Hierbij worden de volgende stappen doorlopen (Figuur 1):

Casuïstiek uit de praktijk

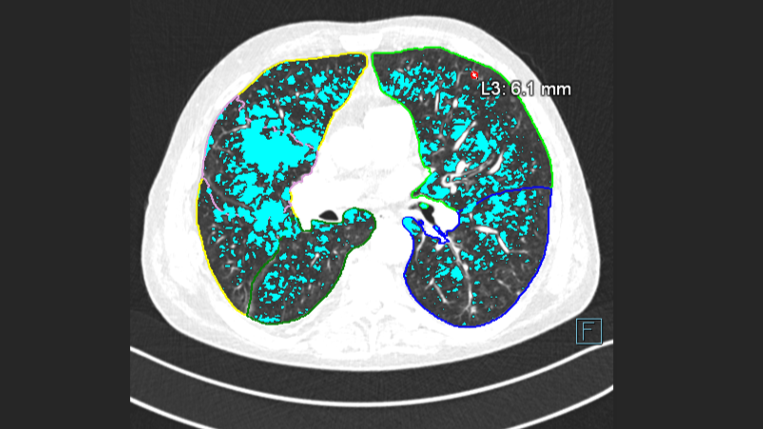

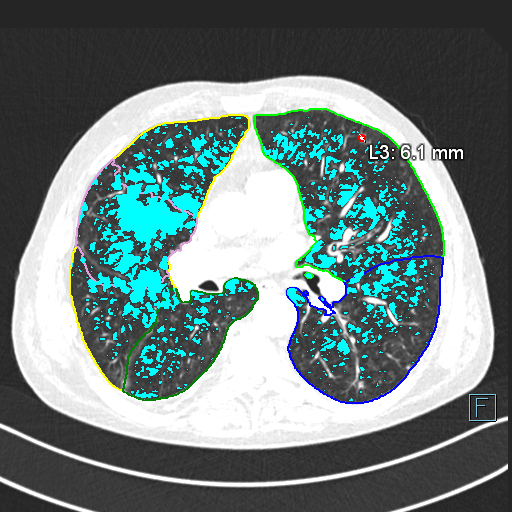

Hoe de kwaliteitscontroles in de praktijk toegepast wordt zal geïllustreerd worden aan de hand van een voorbeeld van de implementatie van AI-software op de afdeling Radiologie van het MSZ. Begin 2022 is daar AI-Rad Companion (Siemens Healthineers) geïmplementeerd voor de ondersteuning bij CT-thorax diagnostiek en meer specifiek voor de detectie van longnoduli en longschade (Figuur 2).

1. Eigenschappen van AI-software

De eigenschappen van de AI-software zijn opgevraagd bij de leverancier, zoals informatie over de modelontwikkeling, prestatie uitkomsten, functionaliteiten en integratiemogelijkheden. Er vielen twee dingen op: allereerst werd duidelijk dat het wetenschappelijke bewijs voor de klinische effectiviteit nog in opbouw is. De literatuur laat met name zien wat er technisch mogelijk is, en niet zozeer of het toepasbaar is in de dagelijkse klinische praktijk en wat de meerwaarde ervan is [16]. Wat ook opviel waren de keuzes in de workflow welke van invloed zijn op de taken van laboranten en radiologen. De keuze om een CT-scan direct vanaf de modaliteit naar de AI-software te sturen zonder tussenkomst van het PACS betekende dat de laborant het juiste scanprotocol moet kiezen en dat de radioloog geen extra controle hoeft uitvoeren op wat er door de AI-software geanalyseerd wordt. Op basis van de gewenste workflow zijn de risico’s in kaart gebracht met het AI-team bestaande uit een radioloog, laborant, functioneel beheerder, teamleider en klinisch informaticus. De risico’s bleken vooral te zitten in de suboptimale presentatie van resultaten in het PACS, het (handmatig) overnemen van verkeerde resultaten in de verslaglegging en de communicatie over het gebruik van AI-software richting aanvragers van het onderzoek en patiënten. Belangrijk dus om niet alleen naar de impact te kijken op de eigen afdeling maar ook voor betrokken stakeholders bij het inzetten van AI-software.

2. Lokale validatie

Na de technische implementatie van AI-Rad Companion en afstemming met betrokken zorgverleners werd het systeem lokaal gevalideerd. Hiervoor zijn o.a. de koppelingen tussen de externe Cloud omgeving en het PACS getest met een testpatiënt. De resultaten die in het PACS terecht kwamen werden beoordeeld door de radioloog op de gewenste functionaliteiten, bijvoorbeeld het bekijken van de resultaten vanuit verschillende aanzichten en de weergave van automatische metingen. Daarnaast willen de radiologen de resultaten van de AI-software vergelijken met de eigen beoordeling als vorm van een statistische validatie. Hiervoor is een historische dataset nodig met een range aan casuïstiek om de prestatie van de AI-software te testen. Al snel werd duidelijk dat daarvoor nieuwe data verzameld moest worden omdat er een andere CT-beeldreconstructie nodig was voor de analyse door de AI-software. Er is besloten om een periode te schaduwdraaien waarbij de AI-software op de achtergrond in “stille modus” meedraait maar de resultaten nog niet actief worden meegenomen in de beoordeling door de radioloog [9]. Als laatste onderdeel van de lokale validatie is een plan gemaakt om de impact van de AI-software in kaart te brengen. Hierbij zal niet alleen gekeken naar relevante klinische uitkomsten maar ook naar de gebruikerservaring. Het idee is om enerzijds aanvullende kritische bevindingen door de AI-software te kwantificeren en anderzijds de mate van adoptie te evalueren. Met name de adoptie van AI-software is een belangrijke factor voor het creëren van meer vertrouwen en daarmee ook opschaling.

3. Real-time monitoring

Het systeem is nu ruim een half jaar actief. Met de leverancier is afgesproken in welke vorm de AI-software gemonitord wordt. In het stappenplan wordt aanbevolen om ten minste te monitoren op: foute voorspellingen, technische fouten, fairness (ongewenste verschillen in uitkomsten bij patientengroepen), risico’s, deployment bias (of de AI-software op de juiste manier wordt gebruikt) en de voordelen. De meeste monitoringsuitkomsten kunnen niet door de applicatie zelf geregistreerd worden. Het is dus belangrijk om dit periodiek in een overlegstructuur met elkaar te bespreken. Met de afdeling radiologie is een halfjaarlijkse termijn afgesproken waarin de veiligheid en effectiviteit van de AI-software geëvalueerd wordt. Voor nu zit de grootste uitdaging in de adoptie onder de gebruikersgroep. In de toekomst zal er bij wijzigingen door updates/upgrades of bij wijzigingen in gebruik opnieuw naar de kwaliteitscontroles gekeken moeten worden. Bijvoorbeeld wegens een verandering in beoogd doelgebruik of de prestatie van AI-software. Daarbij komt ook hoe autonomer de AI-software wordt ingezet, hoe groter de uitdaging op het gebied van veilige toepassing, competenties, vertrouwelijkheid en aansprakelijkheid [17]. Reden genoeg om het gebruik te blijven evalueren.

Lessons learned

Het stappenplan HAI geeft een praktische set aan handvaten die toegepast kunnen worden binnen elke zorgorganisatie. Een mooie stap richting de opschaling van AI-software binnen de zorg. De belangrijkste lessons learned:

- Zorg voor een clinical lead in het AI-team die de meerwaarde van het product kan beoordelen

- Niet alleen het AI-model moet goed werken, nog belangrijker is de interactie tussen het systeem en de gebruiker

- Breng beslissingsondersteunende momenten in het zorgproces in kaart zodat de AI-software op het juiste moment geraadpleegd kan worden

- Fouten, wijzigingen, gebruiksvriendelijkheid, “human-computer agreement” en de manier van integratie of implementatie kunnen bepalende factoren zijn voor de effectiviteit van AI-software

- Houd nieuwe wetgeving relevant voor AI (in de zorg) in de gaten, zoals de Europese AI Act en de European Health Data Space (EHDS) welke mogelijk meer ruimte gaan bieden om met het dynamische karakter van AI-technologie om te gaan

Bij deze ook de uitnodiging om ervaringen in de praktijk meer met elkaar te delen. Binnen de NVKI wordt het stappenplan HAI doorontwikkeld met klinisch informatici en medisch ingenieurs uit andere ziekenhuizen. Leren door te doen, zodat niet alleen het leervermogen van AI-modellen wordt benut maar ook die van de organisatie. Want zoals onze minister van VWS zegt: “Een goede balans tussen grip op de zorgvuldige totstandkoming en toepassing van AI en de flexibiliteit om te kunnen experimenteren én leren.” [18].

Referenties

[1] IMDRF AIMD Working Group. (2021). Machine Learning-enabled Medical Devices—A subset of Artificial Intelligence-enabled Medical Devices: Key Terms and Definitions, 1–16.

[2] US FDA. (2019). Proposed Regulatory Framework for Modifications to Artificial Intelligence / Machine Learning ( AI / ML ) -Based Software as a Medical Device ( SaMD ) – Discussion Paper and Request for Feedback. U.S Food & Drug Administration, 1–20.

[3] Gerke, S., Babic, B., Evgeniou, T., & Cohen, I. G. (2020). The need for a system view to regulate artificial intelligence/machine learning-based software as medical device. Npj Digital Medicine, 3(1), 53.

[4] Muehlematter, U. J., Daniore, P., & Vokinger, K. N. (2021). Approval of artificial intelligence and machine learning-based medical devices in the USA and Europe (2015–20): a comparative analysis. The Lancet Digital Health, 3(3), e195–e203.

[5] van Leeuwen, K. G., Schalekamp, S., Rutten, M. J. C. M., van Ginneken, B., & de Rooij, M. (2021). Artificial intelligence in radiology: 100 commercially available products and their scientific evidence. European Radiology, 31(6), 3797–3804.

[6] M&I Partners. (2021). AI Monitor Ziekenhuizen 2021, (030).

[7] Feng, J., Phillips, R. V., Malenica, I., Bishara, A., Hubbard, A. E., Celi, L. A., & Pirracchio, R. (2022). Clinical artificial intelligence quality improvement: towards continual monitoring and updating of AI algorithms in healthcare. Npj Digital Medicine, 5(1), 1–9.

[8] Uit de blogserie: ‘Gezonde Bytes’ van het Rathenau Instituut (2020). Hierin wordt antwoord gegeven op de vraag: maatschappelijk verantwoorde AI gebruiken in de zorg – wat is dat eigenlijk?

[9] Wiens, J., Saria, S., Sendak, M., Ghassemi, M., Liu, V. X., Doshi-Velez, F., … Goldenberg, A. (2019). Do no harm: a roadmap for responsible machine learning for health care. Nature Medicine, 25(9), 1337–1340.

[10] Stevens, M.J. (2021, June 4). Dreaming with data: Assembling responsible knowledge practices in data-driven healthcare. Erasmus University Rotterdam.

[11] Wehrens, R., Weggelaar, A.M., de Bont, A. (2021). Verantwoord gebruik van AI in de zorg: een pleidooi voor veerkrachtige datapraktijken. Zorgvisie.

[12] Nederlandse Vereniging van Ziekenhuizen. (2016). Convenant Veilig toepassing van medische technologie in de medisch specialistische zorg.

[13] Imming, H. (2018). Praktijkgids medische informatietechnologie.

[14] Smeden, M. Van, Moons, C., Kant, I., & Os, H. Van. (2021). Leidraad voor kwalitatieve diagnostische en prognostische toepassingen van AI in de zorg.

[15] https://www.nvki.nl/community/threads/stappenplan-healthy-ai.471/

[16] Siemens Healthineers (2021). Whitepaper Features, Data, and Algorithms AI-Rad Companion Chest CT. 16 sept 2021.

[17] Bitterman, D. S., Aerts, H. J. W. L., & Mak, R. H. (2020). Approaching autonomy in medical artificial intelligence. The Lancet Digital Health, 2(9), e447–e449.

[18] Ministerie van Volksgezondheid, Welzijn en Sport (2022). Kamerbrief Waardevolle AI voor Gezondheid, 9 mei 2022